Cerebras, một công ty có tuổi đời còn rất trẻ ở thung lũng Silicon, Mỹ, đã tự tìm cho mình một hướng đi hoàn toàn toàn mới trong cuộc đua về chip cho ứng dụng trí tuệ nhân tạo (AI), đó là họ đã tạo ra những con chip có kích thước khổng lồ (siêu chip) mà mỗi wafer chỉ có thể làm ra một chip duy nhất thay vì hàng nghìn, chục nghìn chip như thông thường. Tuy Cerebras mới chỉ thành lập được 5 năm nhưng khi nhìn vào đội ngũ những người thành lập nên Cerebras thì không thể nói họ là những tay mơ được. Vậy chúng ta hãy cùng tìm hiểu xem liệu hướng đi mới này có thực sự là một cuộc cách mạng trong cuộc đua chế tạo sản xuất chip cho AI.

Như chúng ta đã biết, 'Deep learning' - một công nghệ thuộc lĩnh vực AI, hoạt động dựa trên một chuỗi các thuật toán sắp xếp thành từng lớp liên kết với nhau rất phức tạp, gọi là 'mạng thần kinh nhân tạo' (neural network) đã giúp tạo ra những trợ lý giọng nói ảo, xe tự hành và nhà vô địch cờ vây AlphaGo. Hệ thống deep learning có thể chạy trên một máy tính đơn lẻ hoặc một hệ các máy tính kết nối với nhau có kích thước bằng cả tỏa nhà và tất nhiên những hệ thống lớn thì sẽ xử lý những bài toán lớn, phức tạp ví dụ như hệ thống ở trung tâm dữ liệu lớn của Google.

Hệ thống này được cấu tạo từ những mạng lưới rất nhiều máy tính được kết nối với nhau thành từng 'cụm' (clusters), mỗi một cụm có 48 máy server (mỗi máy server có kích thước to gấp đôi cuốn Analog CMOS của thầy Razavi) được đặt sếp chồng lên nhau trên một giá đỡ cao bằng một người trưởng thành; những giá đỡ này lại được xếp thành hàng và lấp đầy một tòa nhà lớn. Tuy nhiên, những hệ thống như thế này cũng đang đặt ra những thách thức lớn cho công tác vận hành. Electrons thì đúng là di chuyển rất nhanh, nhưng giao tiếp giữa những con chip thì vẫn còn hạn chế, khá chậm và đặc biệt là 'căn phòng' này đốt rất nhiều năng lượng. Và câu chuyện Cerebras bắt đầu.

Khởi đầu

Mùa xuân năm 2016, Andrew Feldman, nhà đồng sáng lập của Cerebras đã thu hút sự chú ý của các nhà đầu tư bằng một bài thuyết trình vô cùng đặc biệt. Anh đã bắt đầu bằng việc giới thiệu những thành viên sáng lập của Cerebras, những tên tuổi nổi tiếng trong giới công nghệ chip, thay vì nói về một phát mình phần cứng tuyệt vời nào đó. Chính điều này đã gây tác động rất mạnh tới tâm lý nói KHÔNG với phần cứng của các nhà đầu tư mạo hiểm trong thời đại mà các ứng dụng phần mềm thu hút hàng tỷ lượt người dùng lúc bấy giờ.

Có thế nói không ngoa rằng với sự bùng nổ của các các công ty như Twitter, Uber và eBay,… nơi mà công nghệ phần mềm đóng vai trò quyết định cho những kỳ tích tăng trưởng tựa như Thánh Gióng đó thì đầu tư vào phần cứng là một quyết định vô cùng thiếu sáng suốt. Sau này chính những nhà đầu tư vào Cerebras đã thừa nhận định kiến nói KHÔNG với phần cứng mới chính là điều ngớ ngẩn.

Chúng ta quay trở lại với bài trình bày của nhà đồng sáng lập của Cerebras, để chuẩn bị cho điều đặc biệt, Feldman đã so sánh giữa GPU và CPU. Anh nhắc lại thông tin, loại thứ nhất được thiết kế ban đầu để làm việc với hình ảnh 3D nhưng ngày nay thì GPU được sử dụng rất nhiều cho các hệ thống phục vụ thuật toán 'machine-learning' (học máy). Loại thứ hai - hay còn được gọi là 'bộ xử lý trung tâm' được dùng để thực hiện hầu hết tất cả các tác vụ của một chiếc máy tính. Cuối cùng, Feldman đưa ra ý tưởng một thứ gì đó xếp sát nhau dọc theo đường kẻ, như những GPU nhưng nó không phải là cho việc xử lý đồ họa như những GPU thông thường mà nó được thiết kế riêng đặc biệt cho các thuật toán deep learning, và nó có thể xử lý nhanh gấp hàng trăm lần so với CPU. Cerebras muốn tạo ra một loại chip đặc thù cho trí thông minh nhân tạo.

Đó là một trong những câu chuyện khởi đầu về Cerebras được Eric Vishria, một đối tác chung của Benchmark, một công ty đầu tư mạo hiểm ở San Francisco, nhớ lại. Benchmark cũng chính là tổ chức đầu tư sớm vào các công ty phần mềm như Twitter, Uber và eBay. Quỹ này xét duyệt khoảng 200 hồ sơ mỗi năm và chỉ chọn một để đầu tư. Nghĩa là họ đã phải chọn mặt gửi vàng rất cẩn thận cho mỗi quyết định đầu tư. Thực tình thì Vishria đã nghe nhiều hơn bảy bảy bốn chín lần những lời kêu gọi đầu tư của việc sử dụng deep learning cho bảo mật, y tế, chatbots và nhiều nhiều những ứng dụng khác.

Do đó sau bài thuyết trình từ Cerebras, Vishria đã thảo luận với các kỹ sư từ những công ty mà Benmark đã đầu tư (Zillow, Uber, Stitch Fix); và họ bảo rằng họ đang rất bế tắc trong việc sử dụng những thuật toán AI, cụ thể là việc 'training' (đào tạo) cho các hệ thống 'neural networks' mất quá nhiều thời gian. Google là người tiên phong trong việc sử dụng 'tensor-processing units' với tốc độ xử lý siêu nhanh, một loại chip đặc biệt được thiết kế tối ưu riêng cho AI. Tới đây thì Vishria hiểu ra rằng, AI sẽ là một mỏ vàng lớn, và chúng ta phải cần những người thợ rèn cho việc tạo ra cuốc xẻng.

Năm đó, Benchmark và Foundation Capital (một công ty đầu tư mạo hiểm khác), đã gọi vốn được 27 triệu USD cho Cerebras trong vòng gọi vốn đầu tiên và sau đó là nửa tỷ USD cho vòng tiếp theo. Những công ty khác như Groq, Graphcore hay SambaNova cũng đã kêu gọi được tổng cộng hơn 2 tỷ USD để tham gia cuộc đua này. Nhưng, cách tiếp cận của Cerebras là một thứ gì đó rất độc đáo, duy nhất tới thời điểm này. Thay vì làm những con chip theo cách cũ, rằng là in hàng tá chip trên một tấm silicon wafer, cắt ra rồi nối dây (loại như chúng ta thường thấy này có kích thước bằng cái móng tay), như những gì thông thường ta thấy về việc sản xuất ra những con chip, Cerebras đã tạo ra một con chip ngoại cỡ, có kích thước lớn như một chiếc đĩa. Và chip mà Cerebras tạo ra hiện đang là con chip lớn nhất thế giới.

Kể cả những công ty đối thủ của Cerebras cũng phải thừa nhận đây là một kỳ tích đáng kinh ngạc về mặt khoa học. Trong quá khứ rất nhiều công ty đã cố gắng thiết kế những siêu chip và đều đã thất bạn. Cerebras đã chứng minh rằng vượt qua những thách thức tưởng chừng như không thể đấy là hoàn toàn khả thi và họ hoàn toàn xứng đáng với những lời khen ngợi đó.

Vishra đã thốt lên rằng: 'Một cách thật lòng thì, tôi thấy sự thiếu hiểu biết đôi khi lại có lợi. Vì tôi đã không biết, tôi đã không hiểu được tường tận những muôn vàn khó khăn mà họ đã phải đối mặt để làm được điều này, nên tôi mới có can đảm để đầu tư'.

Nếu chúng ta cùng quay ngược về quá khứ thì có một thực tế rất rõ ràng là máy tính đang ngày càng trở nên nhanh hơn. Điều này thường được giải thích bằng định luật Moore, mặc dù đó không hẳn là một định luật thực sự. Gordon Moore, một trong những người tiên phong, một cây đại thụ trong lĩnh vực chip vi mạch, năm 1965 đã phát biểu rằng: số lượng bóng bán dẫn trên một con chip sẽ tăng gấp đôi sau mỗi 2 năm. Trước đây là Intel và sau này là TSMC đã duy trì tính gần đúng của định luật này. Đằng sau nó là công sức làm việc miệt mài của biết bao nhà khoa học và kỹ sư để làm cho kích thước linh kiện bán dẫn ngày càng được thu nhỏ.

Chỉ khi gần đây kích thước này đang tiệm cận giới hạn vật lý của bước sóng ánh sáng dùng trong các máy quang khắc, người ta mới đặt dấu hỏi tiến trình thu nhỏ kích thước liệu có được tiếp tục trong những năm sắp tới hay nói cách khác số phận của 'định luật' Moore liệu đã tới lúc kết thúc. Cho tới thời điểm này. Một cách khác để kéo dài tuổi thọ của định luật Moore là phát triển các cấu trúc mới nâng cao một cách đáng kể hiệu suất của chip.

Có một câu hỏi mà các kỹ sư thiết kế kiến trúc chip đã đặt ra trong một thời gian dài là một chip duy nhất được tích hợp rất nhiều chức năng, liệu có hoạt động hiệu quả hơn là hàng tá chip với khả năng riêng được kết hợp với nhau?

Cũng giống như một thành phố với tất cả nguồn lực được được nén lại trong một diện tích nhỏ thì có hiệu quả hơn mô hình thành phố trung tâm liên kết với các vùng ngoại ô hay không? Ý tưởng này, lần đầu tiên được thực hiện vào những năm 60 của thế kỷ trước bởi Texas Instruments (TI), đã tạo ra một vài con chip trong một không gian có kích thước chỉ vài inch. Nhưng sau đó họ đã nhận ra vấn đề liên quan đến 'yield'. Đó là luôn luôn có một tỷ lệ sai hỏng nhất định trong quá trình sản xuất, nghĩa là nếu trên một wafer chế tạo được 50 chip giống nhau và trên đó có 2 chip bị hỏng thì ta vẫn còn 48 chip. Nhưng nếu ta chế tạo một hệ thống bao gồm 50 chip có chức năng khác nhau trên một tấm wafer, nếu có 2 chip hỏng thì ta phải bỏ đi cả tấm wafer đó. TI đã tìm ra giải pháp cho vấn đề này nhưng 'công nghệ' và 'nhu cầu' vẫn chưa sẵn sàng tại thời điểm đó.

Vào những năm 80 của thế kỷ trước, một kỹ sư tên là Gene Amdahl lại có cách giải quyết khác và thành lập công ty Trilogy Systems khi mới 18 tuổi. Công ty này sau đó trở thành công ty khởi nghiệp (startup) lớn nhất từng được biết đến ở Thung lũng Silicon khi mà nhận được tới 250 triệu USD đầu tư. Để giải quyết bài toán về yield, Trilogy đã cho dư thêm các thành phần 'redundant components' vào con chip. Cách tiếp cận này đã cải thiện được vấn đề về yield nhưng lại làm giảm tốc độ của chip. Cùng lúc đó, công ty lại phải đối mặt với nhiều vận hạn không may khác: trong đó có vấn đề xảy ra với hệ thống điều hòa không khí, khiến cho bụi mịn đã lọt vào các phôi chip. Đến năm 1984 thì Trilogy chính thức phá sản, 'Chúng tôi đã không lường trước được những khó khăn này' - con trai của Amdahl đã nói với Times như vậy.

Nếu công nghệ của Trilogy thành công, có thể nó đã được dùng cho deep learning chứ không phải GPU, dòng chip vốn được thiết kế dành riêng cho các trò chơi yêu cầu cao về xử lý hình ảnh, đang làm công việc này như hiện nay. Việc GPU vô tình được sử dụng cho các ứng dụng về AI là bởi vì bản chất của tất cả sự ảo diệu mà mạng nơ-ron thần kinh nhân tạo mang lại các phép cộng và phép nhân. Khi một nơ-ron trong mạng lưới tương tác với một nơ-ron khác, bản chất là nơ-ron đấy khuếch đại hoặc làm giảm bớt các tín hiệu của nơ-ron mà nó tương tác, mà cụ thể ở đây là các tín hiệu được nhân lên bởi một hệ số được gọi là trọng số. Và hiệu năng của một hệ thống AI là khả năng cho phép thực hiện song song một số lượng cực kỳ lớn các phép tính nhân này, sau đó được nhóm lại thành một danh sách các số hạng gọi các vector; hoặc là một mạng lưới các số hạng gọi là ma trận; hoặc là một matrix; hoặc là các khối số hạng gọi là tensor.

Chúng ta có thể hiểu là, cách mà GPU được thiết kế để xử lý các hình ảnh (tính toán tập hợp các khối hình ảnh để tạo nên một nhân vật trong video game) cũng tương tự như cộng hay nhân các matrix hay tensor với nhau. Và do đó, GPU đã vô tình trở nên hữu ích trong các thuật toán AI. Nvidia là một công ty chuyên về chip GPU nhưng đã biết nắm lấy cơ hội và tùy chỉnh thiết kế để tối ưu cho deep learning.

Hành trình sản xuất 'siêu chip'

Quay lại câu chuyện khởi nghiệp và bài thuyết trình kêu gọi vốn đâu tư của Celebras lúc đầu, Feldman cho rằng sự việc Trilogy đã tạo ra một cái bóng quá lớn khiến cho mọi người mặc định điều này là không thể, thay vì cố suy nghĩ hướng giải quyết. Do đó, vào năm 2015, Feldman đã cùng với một số kỹ sư chuyên về kiến trúc máy tính mà trước kia từng làm việc ở SeaMicro (một công ty chuyên sản xuất máy chủ - đã được Feldman bán cho A.M.D với giá 34 triệu USD) đã khởi xướng ý tưởng về một con chip có kích thước lớn. Sau 4 tháng nghiên cứu không ngừng, họ đã phác thảo được một giải pháp khả thi; sau đó nhóm nghiên cứu kêu gọi vốn từ Benchmark, Foundation Capital và Eclipse; và bắt đầu tuyển dụng.

Quá trình sản xuất chip vi mạch thường bắt đầu bằng việc nung chảy cát và kéo đơn tinh thể, kết quả sẽ là một khối hình trụ (nhìn giống bình đựng oxy), kích thước đường kính tấm wafer nền là 200mm hay 300mm là phụ thuộc vào khả năng kéo đơn tinh thể này. Các tấm wafer sau đó được mài mỏng rồi bắt đầu các bước phức tạp để khắc các mạch điện lên tấm wafer tạo thành chip. Quá trình khắc này được lặp đi lặp lại trên các vùng khác nhau của tấm wafer và tấm wafer sau đó được cắt ra để tạo thành hàng chục, hàng trăm, hàng nghìn hay hàng chục nghìn con chip. Vấn đề của Celebras là làm sao để khắc được mạch điện lớn trên một vùng diện tích lớn bằng cả tấm wafer vì các máy khắc chip không thể cho phép khắc trên một vùng diện tích quá lớn.

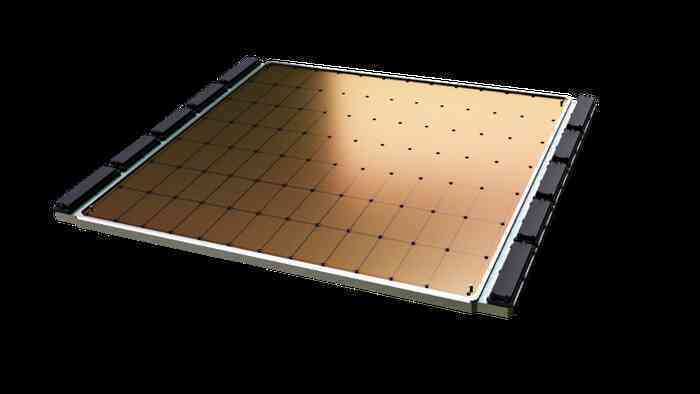

Bộ xử lý Cerebras là một con chip vuông đơn được cắt từ một tấm silicon 300mm (Ảnhh: FT)

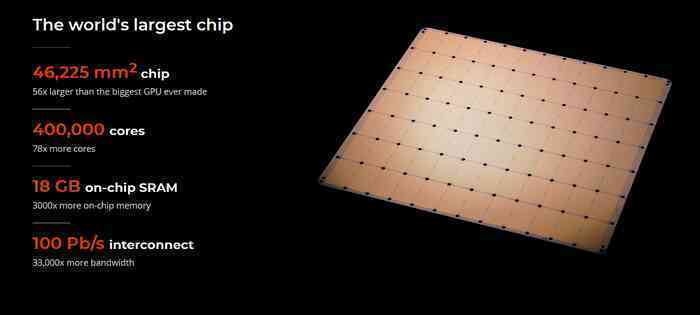

Celebras đã phát minh ra một kỹ thuật tạo ra được những kết nối cho phép giao tiếp giữa các vùng mạch khác nhau. Và kỹ thuật này được phát triển với sự hợp tác của TSMC, cụ thể các vùng mạch được chế tạo chồng lấn nhau ở các cạnh của chúng, do đó, hệ thống dây dẫn được nối với nhau tạo thành con chip duy nhất có quy mô cả tấm wafer có cạnh là 21 cm (so với chip GPU lớn nhất hiện nay chỉ có cạnh xấp xỉ 3cm.) Con chip đầu tiên của Cerebra gọi là WSE-1 (wafer-scale engine 1) được sản xuất năm 2019 và năm nay Cerebras đã giới thiệu WSE-2 có mật độ tích hợp lên tới 2,6 nghìn tỷ bóng bán dẫn, tạo thành con chip có 850.000 đơn vị lõi xử lý trong khi các GPU tốt nhất hiện nay chỉ có thể có vài nghìn đơn vị lõi xử lý và CPU chỉ có khoảng 10 đơn vị lõi xử lý.

Chủ tịch đồng thời là CEO của công ty Synopsys cho biết khi thiết kế chip có quy mô đơn giản, kỹ sư thiết kế vẫn có thể dùng bút chì và giấy để mô tả được luồng dữ liệu đầu vào, nó được xử lý như thế nào? và đầu ra cụ thể sẽ ra sao. Với chip phức tạp hơn các kỹ sư sẽ sử dụng ngôn ngữ mô tả phần cứng, mô tả kiến trúc hệ thống và dùng các phương trình toán học để mô tả luồng luân chuyển dữ liệu. Sau đó phần mềm chuyên dụng sẽ được sử dụng để tổng hợp ra mạch điện và đường kết nối cụ thể giữa các bóng bán dẫn để thực hiện được chức năng mong muốn của các con chip.

Các kết nối này là các đường nối đan chéo, xếp chồng lên nhau thành nhiều lớp như những nút giao thông đường quốc lộ. Sự thực thì nó phức tạp gấp nhiều nhiều lần nút giao thông. Bạn hãy tưởng tượng các kỹ sư của Celebras phải làm việc ở quy mô wafer và mật độ tích hợp là 2,6 nghìn tỷ bóng bán dẫn thì nó sẽ phức tạp đến mức nào. Và phần mềm của Synopsys có sử dụng các thuật toán AI đã giúp các kỹ sư Celebras sắp xếp, thiết kế và thi công mạng lưới đường giao thông phức tạp đó.

Câu hỏi đặt ra là việc thiết kế siêu chip này có lợi gì? Celebras dùng hình ảnh ví von rằng, các bạn sinh viên trong cùng phòng ở một ký túc xá nọ uống bia khi cùng xem một trận bóng đá. Hãy tưởng tượng ký túc xá là một hệ thống AI lớn, các phòng là các lõi, bia trong tủ lạnh là dữ liệu trong bộ nhớ. Các loại bia khác nhau là các loại dữ liệu khác nhau. Thông thường một lõi muốn xử lý một dữ liệu nào đó thường sẽ phải tìm dữ liệu từ những bộ nhớ dùng chung nằm ở vị trí khá xa trên bảng mạch, giống như việc các bạn sinh viên phải đi tới cantin chung của ký túc xá để lấy bia.

Giải pháp của Celebras là trong mỗi phòng đặt một tủ lạnh chứa đầy bia để các bạn sinh viên nhanh chóng lấy bia khi cần mà không phải chạy tới tận phòng cantin chung của ký túc xá. Những dữ liệu thường xuyên nhất (loại bia thường uống nhất) đã được đặt ngay trong phòng và cả ký túc xá (một hệ thống AI) là một con chip, hay nói cách khác bộ não một hệ thống AI thay vì rải rác nằm ở các tủ chứa khác nhau trong một căn phòng thì với giải pháp chip siêu lớn nó được tập trung trong một hộp sọ duy nhất.

Tuy nhiên như đề cập ở phần đầu tiên, làm sao Celebras giải quyết được vấn đề về yield khi khắc một chip duy nhất có kích cỡ bằng cả wafer với giới hạn công nghệ đang có hiện nay là luôn có một tỷ lệ sai hỏng nhất định khi khắc lặp lại nhiều lần để tạo các chip trên wafer. Câu trả lời đến từ chính gợi ý của Trilogy, đó là thêm các mạch dự phòng, tuy nhiên, khác với Trilogy cố gắng tạo ra một con chip đa năng được nối lại với nhau từ các thành phần khác nhau, một thành phần bị lỗi thì có thể được thay thế bằng một thành phần dự phòng khác thì cách mà Celebras đưa ra là họ tạo ra các lõi hoàn toàn giống hệt nhau, nghĩa là nếu một lõi bị hỏng thì các lõi xung quanh vẫn đảm bảo hoạt động tốt.

Gần đây, vào tháng 6, các nhà phát triển của Google đã loan báo một tiến bộ mà họ đạt được trên tờ Nature rằng, họ đã sử dụng các tiến bộ công nghệ AI của họ để phần mềm tham gia vào việc thiết kế chip. Công nghệ AI này cũng chính là công nghệ DeepMind họ sử dụng để mạng nơ-ron nhân tạo được 'huấn luyện' để chiến thắng con người trong môn cờ vây. Kết quả cho thấy máy tính chỉ mất vài giờ để hoàn thành việc sắp xếp hàng nghìn khối bộ nhớ, hàng chục triệu cổng logic và hàng chục km dây nối cực nhỏ cho một chip xử lý TPU (Tensor Processing Unit). Trong khi đó, việc này sẽ mất tới hàng tháng nếu giao cho một nhóm các chuyên gia thực hiện để đạt được cùng hiệu quả về diện tích và năng lượng tiêu tốn.

Và Google cho biết đang áp dụng chính AI vào việc thiết kế TPU. Việc này gợi nhớ chúng ta về thuật ngữ Singularity mà giới khoa học hay đề cập gần đây, nói về thời điểm mà công nghệ đạt tới trí thông minh vượt quá tầm kiềm soát của con người. Gần đây, các hãng cung cấp công cụ thiết kế vi mạch cũng đã nói về việc họ áp dụng AI trong các phần mềm máy tính trợ giúp các kỹ sư trong quá trình thiết kế chip. Hình ảnh minh họa khá ấn tượng là một hình ảnh hai bàn tay một bên là 'Slicon' một bên là 'Smart' đan chéo vào nhau. Và liệu có thể xảy ra kịch bản chính con chip Celebras đã tạo ra sẽ được dùng để thiết kế ra các con chip Cerebras khác?

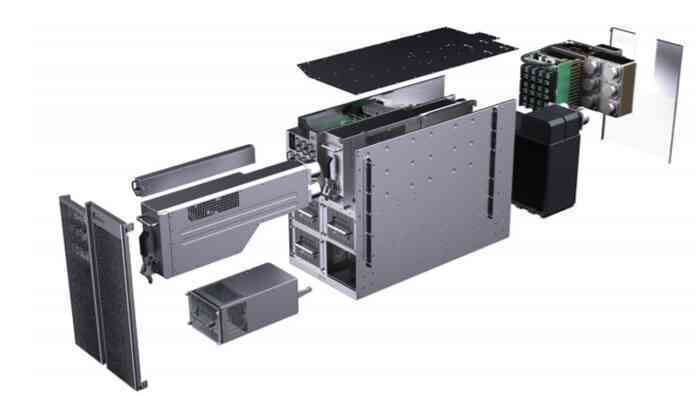

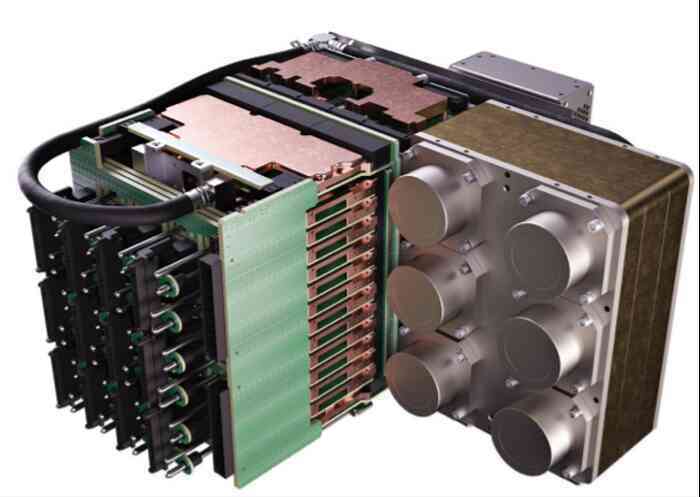

Đối với con người, bộ não chiếm 2% trọng lượng cơ thể nhưng lại sử dụng tới 20% lượng calo của chúng ta, điều này cũng hoàn toàn đúng với chip silicon. Chip khổng lồ của Celebras tiêu tốn 15kW điện trong khi một chip máy tính lớn chỉ tiêu tốn khảng 350 watt điện năng. 15kW lượng điện năng đủ để vận hành một ngôi nhà, điều này là quá sức tưởng tượng vì chưa một ai từng nghĩ sẽ giao nhiều năng lượng đến vậy cho một con chip. Cuối cùng thì ¾ kích thước máy tính CS-1 được xây dựng dựa trên chip WSE-1 chỉ được dùng để làm mát cho WSE-1. Khi hầu hết các máy tính khác sử dụng quạt thổi không khí mát qua bộ vi xử lý thì CS-1 dùng nước để làm mát. Khi nước ấm lên, sẽ làm giãn nở đường ống và việc sử lý đường ống này để nó không làm xước WSE-1 cũng là một thách thức đối với các kỹ sư Celebras. Riêng việc phát minh ra vật liệu dùng để dẫn nhiệt và có thể bảo vệ WSE-1 khỏi áp lực của các ống dẫn nước cũng lên đến cả năm trời. Cuối cùng thì một thiết kế trông đẹp như một bức tranh nghệ thuật đã xuất hiện như hình dưới đây.

Hình ảnh bên trong của máy tính CS-2, từ trái sang phải: mặt trước, quạt, bơm, nguồn, khung máy, bộ tản nhiệt, khối máy chính, mặt sau. (Ảnh: Celebras)

Khối máy chính của CS-2, trong đó là WSE-2 và hệ thống làm mát bằng nước. (Ảnh: Celebras)

Sức mạnh mà hệ thống mà Celebras tạo ra mạnh mẽ tới mức nào?

CS-1 có mức giá khoảng 2 triệu USD, khách hàng của nó là phòng thí nghiệm Quốc gia Lawrence Livermore, Trung tâm Siêu máy tính Pittsburgh và EPCC, trung tâm siêu máy tính tại Đại học (ĐH) Edinburgh, các công ty dược phẩm, công nghiệp, các 'khách hàng quân sự và tình báo.'

Trong một bài đăng blog, một kỹ sư tại công ty dược phẩm AstraZeneca cho biết họ đã sử dụng CS-1 để đào tạo một mạng nơ-ron nhân tạo có khả năng trích xuất thông tin từ một lượng lớn các tài liệu nghiên cứu chỉ trong 2 ngày, trong khi đó một hệ thống khác gồm một tổ hợp lớn các GPU cần tới 2 tuần. Phòng thí nghiệm Công nghệ Năng lượng Quốc gia Hoa Kỳ cũng cho biết CS-1 đã giải một hệ phương trình nhanh hơn siêu máy tính của họ tới hơn 200 lần, trong khi chỉ sử dụng 'một phần nhỏ' điện năng tiêu thụ. Các nhà nghiên cứu cũng cho rằng đây là hệ thống đầu tiên có năng lực nhanh hơn hệ thống mô phỏng thời gian thực của hàng triệu tế bào trong các mô hình động lực học thực tế. Do việc mở rộng quy mô là không hiệu quả nên chưa có phiên bản siêu máy tính nào của họ đủ lớn để đánh bại CS-1.

Bronis de Supinski, Giám đốc công nghệ cho Livermore, phòng thí nghiệm đang chạy những siêu máy tính nhanh nhất thế giới, cho biết: các thử nghiệm ban đầu cho thấy CS-1 mang lại hiệu suất chạy mạng nơ-ron nhân tạo tên mỗi bóng bán dẫn cao hơn khoảng 5 lần so với các cụ GPU và làm tăng đáng kể tốc độ đào tạo (training) mạng nơ-ron nhân tạo.

Kim Branson, người đứng đầu nhóm AI của GlaxoSmithKline cho biết họ đã sử dụng CS-1 để thực hiện nhiệm vụ phân tích trình tự DNA và dự đoán kết quả của các đột biến, đây là một phần trong việc hợp tác với Jennifer Doudna, nhà khoa học hóa sinh thuộc ĐH Berkeley, người đã đạt chung giải Nobel năm ngoái cho công trình về CRISPR. Và CS-1 đã cho thấy nó nhanh hơn khoảng 80 lần so với cụm 16 GPU mà Kim Brason đang sử dụng trong việc giải mã trình tự DNA. Ngoài ra, vì CS-1 cũng cho thấy trải nghiệm người dùng dễ chịu hơn vì việc thiết lập trên một máy tính thống nhất là đơn giản hơn việc thiết lập cho một mạng lưới các máy tính và họ đang rất mong đợi sự ra mắt của CS-2 với năng lực tăng gấp đôi về bộ nhớ và mật độ bóng bán dẫn.

Gần đây khi định luật Moore chạm tới giới hạn vật lý khi kích thước các bóng bán dẫn chạm tới kích thước của một vài nguyên tử, người ta bắt đầu nói tới một định luật Moore thứ hai, đó là chi phí của các nhà máy chế tạo sẽ tăng theo cấp số nhân. Vừa rồi chính TSMC đã thông báo họ sẽ tăng giá chip lên 20% trong bối cảnh họ đang có kế hoạch bỏ ra hàng chục tỷ USD là để xây dựng năng lực sản xuất chip với tiến trình công nghệ cho phép chế tạo được kích thước bóng bán dẫn nhỏ hơn nữa. 20 năm trước có khoảng 25 công ty có thể tạo ra các con chip với tiến trình công nghệ tiên tiến nhưng hiện nay chỉ còn vài ba công ty có được năng lực này, gồm: TSMC, Samsung và Intel.

Trong bối cảnh này, các chip WSE-1 và WSE-2 cho thấy một hướng đi khác, chúng không chạy đua về tỷ lệ tích hợp bao nhiêu bóng bán dẫn trên một đơn vị diện tích milimet vuông, mà chúng tập trung vào việc tối ưu hóa sắp xếp mức kiến trúc của các phần tử tính toán cho các ứng dụng cụ thể. Thiết kế chip sẽ giống như thiết kế ô tô ngày càng cần cá nhân hóa người dùng, ví dụ ta cần xe tải lớn để chở gạch, đá; một xe nhỏ hơn để chở gia đình đi chơi vào cuối tuần. Và chip của Celebras là chỉ để dùng cho AI.

Dành cho phần cuối, chúng ta hãy quay trở lại với anh chàng Vishria, nhà đầu tư mạo hiểm vào công ty Celebra, anh ta đã mô tả ngành công nghiệp chip bán dẫn đã trải qua 4 giai đoạn: giai đoạn 1 bắt đầu những năm 1980, khi đó máy tính cá nhân yêu cầu những vi xử lý đa năng (CPU) và Intel đã trở thành công ty dẫn đầu. Sau đó giai đoạn 2 bắt đầu vào những năm 1990, sự phát triển của trò chơi điện tử đã thúc đẩy sự phát triển của GPU và giúp Nvidia đã thống trị giai đoạn này.

Sự bùng nổ Internet, mạng máy tính sau đó khởi đầu cho giai đoạn 3 với đòi hỏi thời gian đáp ứng nhanh và Broadcom là công ty đã chiếm ưu thế. Vào những năm đầu thế kỷ 21, sự gia tăng của các thiết bị di động kéo theo yêu cầu về năng lực xử lý hiệu quả của vấn đề năng lượng tiêu thụ là giai đoạn 4 mà Qualcomn và ARM đang là những người chiến thắng.

Ảnh: inquisitiveuniverse.com

Chúng ta có thể đang bắt đầu giai đoạn thứ 5 khi mà deep-learning đang đảm nhận công viêc phải xử lý một khối lượng dữ liệu hớn hơn bất kỳ công việc nào trong 4 giai đoạn trước đó thì chip dành riêng cho AI là công việc trọng tâm trong hai thập kỷ thay đổi tiếp theo của nhân loại.

Kỷ nguyên những thiết kế chip dành cho AI sắp diễn ra?

Cách tiếp cận của Celebras là một khả năng, điều đáng nói ở đây là sắp tới chúng ta sẽ chứng kiến sự bùng nổ của kỷ nguyên những thiết kế chip dành cho AI. Và với AI thì nó cho thấy khả năng chúng ta sẽ không cần tuân theo một quy tắc thiết kế sản xuất chip cũ nữa. Hiện đang có hơn 200 startup đang thiết kế chip AI trong một thị trường mà người ta ước đoán sẽ đạt 100 tỷ USD vào năm 2025. Và không phải tất cả các chip đều yêu cầu năng lực xử lý lớn như trong các trung tâm dữ liệu, một số chip AI sẽ được dùng cho máy trợ thính, camera chuông cửa hoặc trong các ô tô tự lái của tương lai (cả Tesla và Volkswagen đều đang thiết kế chip của riêng họ).

Ngành công nghiệp chip sẽ tiếp tục phát triển, ngày càng đa dạng hóa để phục vụ mọi nhu cầu của đời sống. Có thể Celebras Wafer-Scale Engine không thay thế cho Nvidia GPU (vì không phải ai cũng cần bộ siêu não 2 triệu USD) nhưng có thể với Celebras chúng ta đã đánh dấu cho một cột mốc quan trọng, thời đại của của những bộ não lớn đã đến./.